1. 評価概要

目的: 韓国語法令および条例検索(RAG)システムに最適化された埋め込みモデルの選定

評価データセット

- KCL-MCQA(韓国正準法律ベンチマーク)

- 282個の質問、867個の判例(エキスパートタグ付けGround Truth)

データ選定の理由

- 現在、韓国語法令・条例の公開ベンチマークデータセットが存在しない

- KCL-MCQAは法律ドメインで検証された唯一の韓国語検索評価データセット

- 判例と法令・条例は同一の法律用語および文体を共有し、同様の埋め込み性能を期待可能

- 将来、法令・条例専用評価データセット構築時の再評価を推奨

評価環境

- 検索エンジン:PostgreSQL pgvector with HNSW index

- 評価指標:Recall@5、Precision@5、MRR、NDCG@5

2. 比較モデル

| モデル | プロバイダ | 次元 | 特徴 |

|---|---|---|---|

| Amazon Titan V2 | AWS Bedrock | 1024 | AWS ネイティブ、低コスト |

| Cohere Embed V4 | AWS Bedrock | 1536 | 多言語特化、高性能 |

| KURE-v1 | HuggingFace(SageMaker提供が必要) | 1024 | 韓国語特化オープンソース |

3. 評価指標の説明

Recall@K(再現率)⭐⭐⭐

定義: 実際の関連文書のうち、上位K件の結果に含まれる割合

計算式: (上位K件で見つかった関連文書数)/(すべての関連文書数)

解釈

- 値が高いほど、関連文書を漏れなく検出

- 法律検索で最も重要な指標(漏れ防止)

例: 関連判例が5件あるが、上位5件結果に3件含まれる場合 → Recall@5 = 60%

Precision@K(適合率)⭐

定義: 上位K件結果のうち、実際の関連文書の割合

計算式: (上位K件で見つかった関連文書数)/ K

解釈

- 値が高いほど、検索結果に不要な文書が少ない

- ユーザーが確認すべき文書数を削減

例: 上位5件結果のうち3件が実際の関連文書 → Precision@5 = 60%

MRR(平均逆順位)⭐⭐

定義: 最初の関連文書が現れた順位の逆数の平均

計算式: 1 /(最初の関連文書の順位)

解釈

- 値が高いほど、関連文書が上位に早く登場

- ユーザーが最初に見る結果の品質を測定

例

- 1番目の結果が関連文書 → MRR = 1.0

- 3番目の結果が最初の関連文書 → MRR = 0.33

NDCG@K(正規化割引累積利得)⭐⭐

定義: ランクを考慮した検索品質の総合スコア

解釈

- 関連文書が上位にあるほど高いスコア

- 「あるかないか」ではなく「どこにあるか」を評価

- 0~1の値、1に近いほど理想的なランク

例: 関連文書が1、2位にあると高いスコア、8、9位にあると低いスコア

4. 評価結果

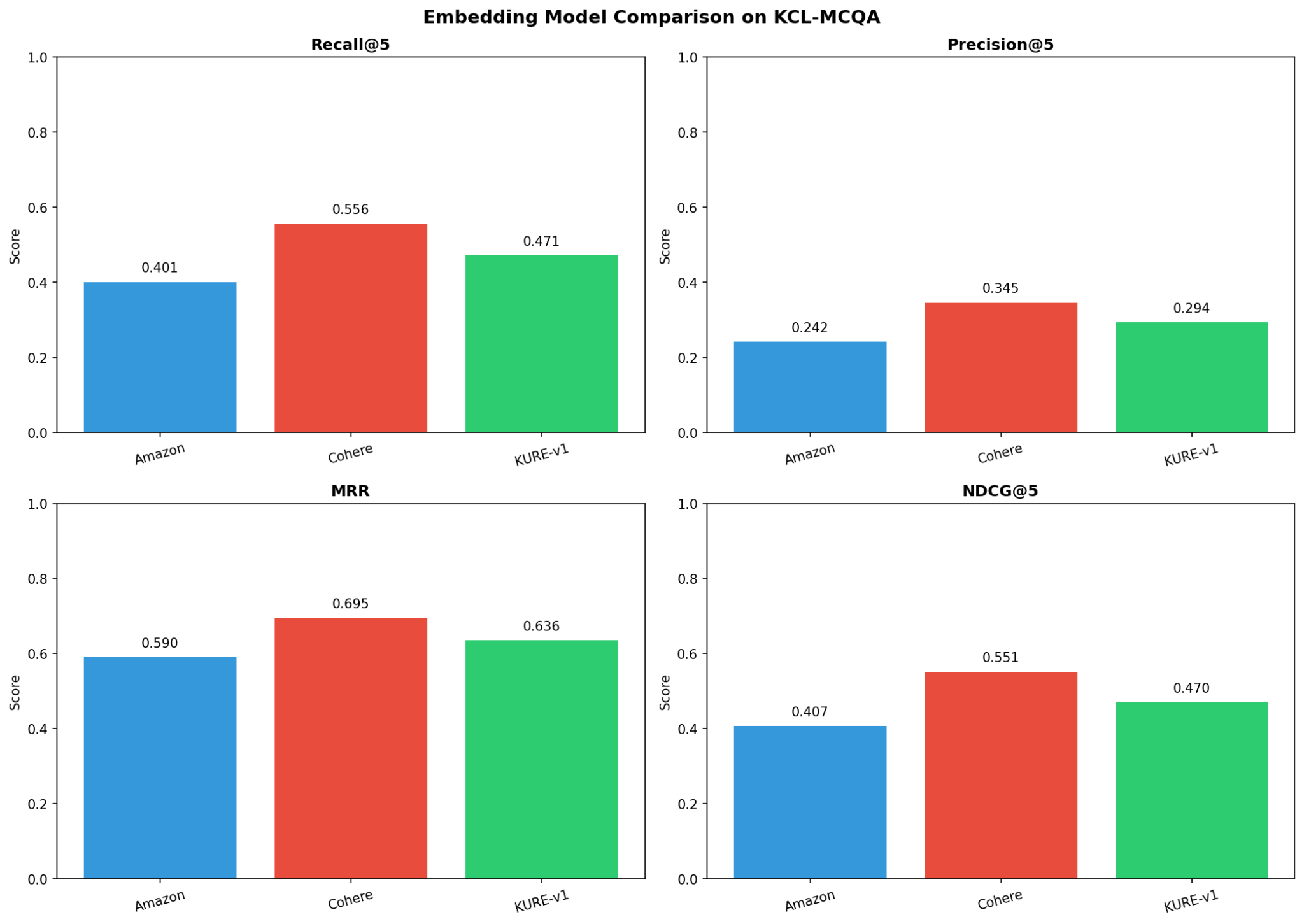

4.1 性能指標の比較

| モデル | Recall@5 | Precision@5 | MRR | NDCG@5 | 順位 |

|---|---|---|---|---|---|

| Cohere Embed V4 | 55.60% | 34.54% | 69.45% | 55.14% | 1位 |

| KURE-v1 | 47.15% | 29.36% | 63.57% | 47.02% | 2位 |

| Amazon Titan V2 | 40.09% | 24.18% | 59.00% | 40.68% | 3位 |

4.2 性能比較チャート

図:3つのモデルの性能指標比較

4.3 性能差分析

| 比較 | Recall差 | 改善率 | MRR差 | 改善率 |

|---|---|---|---|---|

| Cohere vs Titan | +15.5%p | 38.7% | +10.5%p | 17.7% |

| Cohere vs KURE | +8.5%p | 17.9% | +5.9%p | 9.3% |

| KURE vs Titan | +7.1%p | 17.6% | +4.6%p | 7.7% |

4.4 主要な知見

- Cohere Embed V4がすべての指標で1位

- 韓国語特化KURE-v1は汎用Titan V2を上回るが、Cohereには及ばない

- MRR差はRecall差より小さい → すべてのモデルが「最初の結果」は比較的よく検出

5. コスト分析

5.1 埋め込みAPI費用(Bedrock)

| モデル | 価格(1K tokens) | 1,000文書の費用 | 100万文書の費用 |

|---|---|---|---|

| Amazon Titan V2 | $0.00002 | $0.012 | $12.30 |

| Cohere Embed V4 | $0.00012 | $0.060 | $60.00 |

5.2 KURE-v1提供費用(SageMaker)

KURE-v1はオープンソースですが、提供にはSageMakerインフラが必要です。

| 提供方式 | メモリ/インスタンス | 時間当たりコスト | 月間10万リクエスト | 備考 |

|---|---|---|---|---|

| Serverless | 4GB | ~$0.0000467/秒 | $5-10 | 変動費 |

| リアルタイム | ml.g4dn.xlarge | ~$0.7364/時間 | $530 | 固定費 |

5.3 月間運営費用比較(10万リクエスト基準)

| モデル | 提供方式 | 月額費用 | 管理負担 |

|---|---|---|---|

| Titan V2 | Bedrock API | ~$1.23 | なし |

| Cohere V4 | Bedrock API | ~$6.00 | なし |

| KURE-v1 | SageMaker Serverless | ~$5-10 | 中程度(コールドスタート) |

| KURE-v1 | SageMaker リアルタイム | ~$50-100 | 高い(インスタンス管理) |

6. モデル別詳細分析

6.1 Cohere Embed V4

| 項目 | 内容 |

|---|---|

| 強点 | - 最高性能(Recall 55.6%) - 多言語学習による韓国語法律用語の高い理解度 - Bedrock統合による運用の簡便性 |

| 弱点 | - Titan比で約5倍高いコスト |

| 適切な用途 | 法律サービス、精度が重要なB2Bサービス |

6.2 KURE-v1(Korea University)

| 項目 | 内容 |

|---|---|

| 強点 | - 韓国語特化学習 - オープンソースのカスタマイズが可能 - 1024次元で保存効率が高い |

| 弱点 | - SageMaker提供が必要(インフラ管理追加) - Serverlessコールドスタート遅延(数秒) - リアルタイムエンドポイントはコスト負担 - Cohere比で性能が8.5%p低い |

| 適切な用途 | ファインチューニング/カスタマイズが必要な場合、内部システム(遅延許容可能) |

6.3 Amazon Titan V2

| 項目 | 内容 |

|---|---|

| 強点 | - 最も低コスト - Bedrock ネイティブ統合 - 運用の複雑度が最小 |

| 弱点 | - 最低性能(Recall 40.1%) - 韓国語法律ドメインの最適化不足 |

| 適切な用途 | MVP/プロトタイプ、コスト敏感なサービス、精度より速度/コストが重要な場合 |

7. 推奨事項

7.1 最終推奨

Cohere Embed V4

法律ドメインでの15%pのRecall差はコスト差よりもはるかに重要です。

7.2 推奨理由

- 法律ドメイン特性

関連法令・条例の漏れは誤った法律解釈につながる可能性があります。

- Recall 55.6% vs 40.1% = 10件クエリあたり1.5件の追加検出

- この1.5件が重要な条文である可能性がある

- コストの相対的意味

| 項目 | コスト |

|---|---|

| Cohere追加費用(月10万リクエスト) | $4.77 |

| 法律サービス1件の受任料 | 数百万円以上 |

→ ROI観点ではCohere費用はごく僅か

- 運用の便宜

- Bedrock APIで基盤管理不要

- KURE-v1比でSageMaker運用負担なし

8. 結論

性能ランキング

| 順位 | モデル | Recall@5 | 特徴 |

|---|---|---|---|

| 1 | Cohere Embed V4 | 55.6% | 最高性能 |

| 2 | KURE-v1 | 47.2% | 韓国語特化 |

| 3 | Amazon Titan V2 | 40.1% | 低コスト |

主要洞察

| 観点 | 結論 |

|---|---|

| 絶対性能 | Cohere V4がすべての指標で優位 |

| コスト効率 | Titan V2が最も効率的だが性能低下が大きい |

| 韓国語特化 | KURE-v1がTitanより優位だがCohereに及ばない |

| 運用便宜性 | Bedrock モデル(Titan、Cohere)がSageMakerより簡便 |

最終結論

法律ドメインの核心的価値は「信頼性」です。

Cohere V4の55.6% Recallは完璧ではありませんが、Titan V2の40.1%やKURE-v1の47.2%よりもはるかに信頼できます。

法令・条例検索における「見逃した重要な条文」のリスクは、月数ドルのコスト削減では相殺できません。

したがって、Cohere Embed V4を強く推奨します。

附録:評価環境

| 項目 | 詳細 |

|---|---|

| 評価日 | 2026年1月 |

| データセット | KCL-MCQA(lbox/kcl) |

| 評価クエリ | 282個 |

| コーパス | 867個の判例文書(500文字以上) |

| 検索エンジン | PostgreSQL 16 + pgvector 0.7 |

| インデックス | HNSW(m=16、ef_construction=64) |